gpt系统,人工智能领域的突破与创新

时间:2024-10-19 来源:网络 人气:

GPT系统:人工智能领域的突破与创新

一、GPT系统的原理

1. Transformer模型

Transformer模型是GPT系统的核心,它是一种基于自注意力机制的深度神经网络。与传统的循环神经网络(RNN)相比,Transformer模型在处理长序列数据时具有更高的效率和准确性。

2. 预训练与微调

在GPT系统中,首先对大量文本数据进行预训练,使模型具备一定的语言理解能力。然后,针对特定任务进行微调,进一步提升模型在特定领域的表现。

3. 自注意力机制

自注意力机制是Transformer模型的关键,它允许模型在处理序列数据时,关注序列中不同位置的信息,从而提高模型的表示能力。

二、GPT系统的应用

1. 文本生成

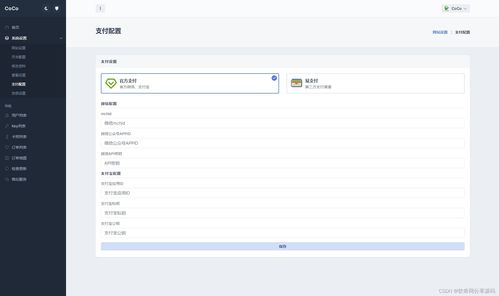

GPT系统在文本生成领域具有广泛的应用,如自动写作、机器翻译、对话系统等。通过训练,GPT模型可以生成高质量的文本,满足不同场景的需求。

2. 问答系统

GPT系统在问答系统中的应用主要体现在自动问答、智能客服等方面。通过训练,GPT模型可以理解用户的问题,并给出准确的答案。

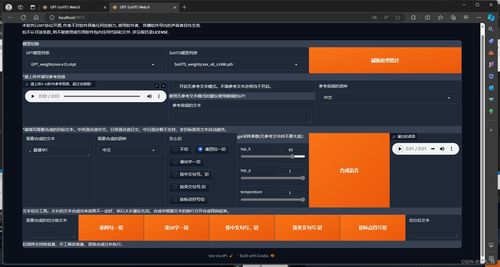

3. 语音识别与合成

GPT系统在语音识别与合成领域也取得了显著成果。通过结合语音识别和语音合成技术,GPT模型可以实现人机对话、语音助手等功能。

三、GPT系统的未来发展趋势

1. 模型轻量化

随着GPT模型在各个领域的应用,模型轻量化成为未来发展趋势。通过模型压缩、知识蒸馏等技术,降低模型复杂度,提高模型在移动设备上的运行效率。

2. 多模态融合

未来,GPT系统将与其他模态(如图像、视频)进行融合,实现跨模态信息处理。这将有助于提高模型在复杂场景下的表现,拓展应用领域。

3. 自适应学习

自适应学习是GPT系统未来发展的另一个重要方向。通过不断学习用户反馈,GPT模型可以不断优化自身性能,提供更加个性化的服务。

GPT系统作为人工智能领域的重要突破,为自然语言处理带来了前所未有的可能性。随着技术的不断发展,GPT系统将在各个领域发挥越来越重要的作用,推动人工智能技术的进步。

相关推荐

教程资讯

教程资讯排行