hdfs系统架构,HDFS系统架构详解

时间:2024-12-01 来源:网络 人气:

HDFS系统架构详解

随着大数据时代的到来,海量数据的存储和计算成为了一个亟待解决的问题。HDFS(Hadoop Distributed File System)作为Hadoop生态系统中的核心组件,为大数据存储提供了高效、可靠的解决方案。本文将详细介绍HDFS的系统架构,帮助读者更好地理解其工作原理。

一、HDFS概述

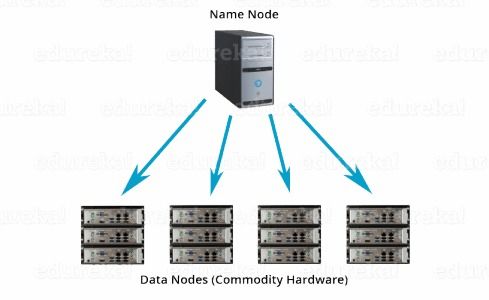

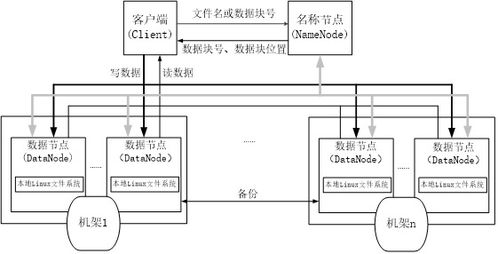

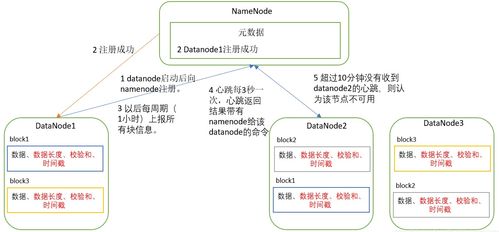

HDFS是一个分布式文件系统,旨在为大规模数据存储提供高吞吐量和容错能力。它由多个服务器组成,包括一个主节点(NameNode)和多个从节点(DataNode)。HDFS的设计目标是存储大量数据,并允许数据被并行访问。

二、HDFS架构组成

1. 数据块(Block)

HDFS将文件分割成固定大小的数据块,默认大小为128MB或256MB。这种设计使得数据可以高效地存储在磁盘上,并便于并行处理。

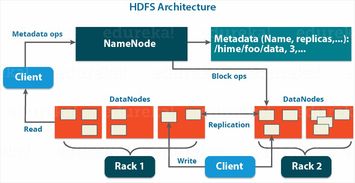

2. 元数据(MetaData)

元数据包括文件名、目录结构、文件属性、数据块列表以及数据块在DataNode上的存储位置等信息。NameNode负责存储和管理这些元数据。

3. NameNode

NameNode是HDFS的主节点,负责管理文件系统的命名空间和客户端对文件的访问。它存储所有文件的元数据,并协调DataNode之间的数据传输。

4. DataNode

DataNode是HDFS的从节点,负责存储实际的数据块。每个DataNode定期向NameNode发送心跳信息,报告其存储的数据块状态。

5. Secondary NameNode

Secondary NameNode负责定期备份NameNode的元数据,以防止数据丢失。当NameNode发生故障时,Secondary NameNode可以快速恢复元数据。

三、HDFS工作原理

1. 写文件流程

(1)客户端向NameNode发送写请求,请求创建文件。

(2)NameNode检查文件名是否已存在,并分配一个唯一的文件ID。

(3)NameNode将文件分割成多个数据块,并记录每个数据块的存储位置。

(4)NameNode将数据块分配给多个DataNode,并通知客户端。

(5)客户端将数据块写入对应的DataNode。

2. 读文件流程

(1)客户端向NameNode发送读请求,请求读取文件。

(2)NameNode根据文件ID查找数据块的存储位置。

(3)NameNode将数据块的存储位置返回给客户端。

(4)客户端直接从DataNode读取数据块。

四、HDFS特点

1. 高容错性

HDFS采用数据副本机制,将数据块复制到多个DataNode上,确保数据不会因单个节点故障而丢失。

2. 高吞吐量

HDFS支持并行读写操作,能够高效地处理大规模数据。

3. 简单的一致性模型

HDFS采用主从架构,简化了数据一致性问题。

4. 移动计算比移动数据更经济

HDFS将计算任务分配到数据所在的节点上,减少了数据传输的开销。

5. 可移植性

HDFS可以运行在多种硬件和操作系统上,具有良好的可移植性。

HDFS作为大数据存储的核心组件,具有高容错性、高吞吐量、简单的一致性模型等特点,为大数据存储提供了可靠的解决方案。了解HDFS的系统架构和工作原理,有助于更好地利用Hadoop生态系统处理海量数据。

相关推荐

教程资讯

教程资讯排行