怎么用jieba分词做一个分词系统,jieba分词工具三种分词模式

时间:2024-09-12 来源:网络 人气:

怎么用jieba分词做一个分词系统目录

怎么用jieba分词做一个分词系统

用Jieba分词建立分词系统的指南。

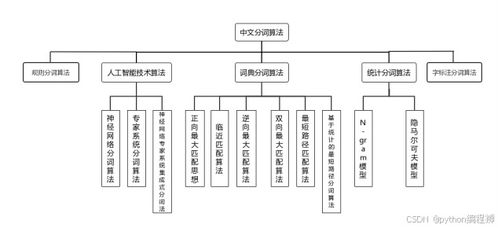

在自然语言处理(NLP)中,中文的分词是基础且重要的步骤。它可以将连续的中文文本切割成有含义的单词,支持后续的文本分析、情感分析和机器翻译等任务。Jieba分词作为一种优秀的中文分词工具,因其效率和易用性而被广泛使用。本文将介绍使用Jieba分词构建简单分词系统的方法。系统需求分析。

在构建分词系统之前,有必要明确系统的需求。-分词模式:支持精确模式、完整模式、搜索引擎模式。-自定义词典:用户可以添加自定义词典。-词性书写:提供词性书写功能,帮助识别名词、动词等。-接口设计:提供API接口,方便其他系统调用分词服务。环境建设。

我们需要创建一个适合分词的环境。构建环境的步骤如下。1.安装Python

确保你已经安装了Python。推荐3.6和2。安装Jieba分词库

使用pip命令安装Jieba:```bashpip install Jieba ``` 3.放置磁场分词

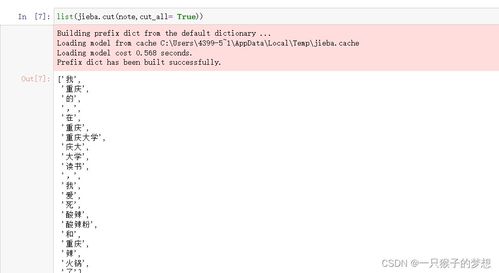

在Python代码中,首先需要引入jieba库,设置分词模式:```pythonimportjieba将分词模式设置为模式jieb .enable_parallel(4)使用4个线程设计并行分词系统```

接下来,设计一个简单的分词系统。系统的主要组成部分如下:

输入处理模块接收用户输入的文本,并将其传递给分词模块。2.分词模块。

分词模块将输入的文本在Jieba分词库中进行分词处理。可以根据需要改变分词的模式。3.输出处理

输出处理模块会像列表一样友好地显示分词结果。代码实现。

以下是一个简单的分词系统实现:```pythonimport jiebadef segment_text(text, mode='default'): jieba分词工具三种分词模式">jieba分词工具三种分词模式

jieba分词工具的三种分词模式详解

jieba分词工具是Pytho上很受欢迎的中文分词库,可以将连续的中文文本切割成有意义的单词单位。jieba分词工具提供了三种主要的分词模式,每种模式都有各自的应用场景和特点。

一、精确模式。

模式是jieba分词工具中最常见的分词模式之一。以最准确地拆分文章为目标,适用于文章分析、情感分析等需要正确理解文章内容的场合。

在模式下,jieba会尽量减少分词误差,将文本切割成最合适的单词。例如,“我爱北京天安门”这句话,“我/爱北京/天安门”的分词切分得很准确。

相关推荐

教程资讯

教程资讯排行